هر بار که گوشی شما قفل چهره را باز میکند، هر بار که گوگل چیزی را که میخواهید تایپ کنید حدس میزند، و هر بار که یک چت بات جوابتان را میدهد، در واقع با هوش مصنوعی طرفید. اما این فناوری قرار است فقط کمک یار بماند یا روزی تصمیم گیر اصلی شود؟

هوش مصنوعی (AI) بدون شک یکی از تحول آفرین ترین فناوری های تاریخ بشر است. از تشخیص بیماریها با دقتی بیشتر از انسان تا بهینه سازی زنجیرههای تأمین جهانی، فرصتهایی که AI پیش روی ما قرار میدهد بیپایان به نظر میرسند. اما در کنار این چشمانداز روشن، سایههایی از نگرانی و عدم قطعیت نیز وجود دارد. این دوگانگی، قلب بحثهای امروزی درباره آینده هوش مصنوعی است.

هدف این مقاله، ارائه یک نگاه واقعبینانه، جامع و بدون اغراق به خطرات هوش مصنوعی و راههای مدیریت آنهاست. ما قصد نداریم این فناوری را شیطhنی جلوه دهیم، بلکه میخواهیم با درک عمیقتر چالشهای پیش رو، اطمینان حاصل کنیم که این ابزار قدرتمند در خدمت بشریت باقی میماند. اگر میخواهید با مفهوم پایه این فناوری بیشتر آشنا شوید، پیشنهاد میکنیم ابتدا مقاله «هوش مصنوعی چیست؟» را مطالعه کنید.

هوش مصنوعی چیست و چرا بحث درباره خطرات آن ضروری است؟

به زبان ساده، هوش مصنوعی (Artificial Intelligence) شاخهای از علوم کامپیوتر است که به ساخت ماشینهای هوشمندی میپردازد که میتوانند کارهایی را انجام دهند که معمولاً به هوش انسانی نیاز دارد؛ کارهایی مانند یادگیری، استدلال، حل مسئله، درک زبان و ادراک بصری.

اما چرا حالا بحث در مورد جنبههای تاریک آن اینقدر داغ شده است؟ چون هوش مصنوعی دیگر یک مفهوم تخیلی نیست. این فناوری از آزمایشگاهها خارج شده و در تار و پود زندگی روزمره ما نفوذ کرده است. از الگوریتمهایی که ویدئوهای یوتیوب را به ما پیشنهاد میدهند تا سیستمهایی که رزومهها را برای استخدام بررسی میکنند، AI در حال گرفتن تصمیماتی است که مستقیماً بر زندگی ما تأثیر میگذارد. به همین دلیل، صحبت در مورد خطرات هوش مصنوعی یک ضرورت است، نه یک بدبینی بی مورد.

آیا میدانستید؟ الگوریتم های هوش مصنوعی همین حالا در حال تصمیم گیری در مورد وام بانکی شما، پیشنهادهای شغلی که دریافت میکنید و حتی محتوایی هستند که در شبکههای اجتماعی میبینید. این تصمیمات همیشه بیطرفانه یا به نفع شما نیستند.

دسته بندی اصلی خطرات هوش مصنوعی: از امروز تا آینده دور

خطرات مرتبط با هوش مصنوعی یک طیف گسترده را پوشش میدهند. برخی از آنها همین امروز وجود دارند و ما با پیامدهایشان دست و پنجه نرم میکنیم، در حالی که برخی دیگر تهدیداتی برای آیندهای هستند که باید از هماکنون برای آن آماده شویم. در ادامه، این خطرات را در چهار دسته اصلی بررسی میکنیم.

۱. خطرات اقتصادی و اجتماعی: بیکاری گسترده و تشدید نابرابری

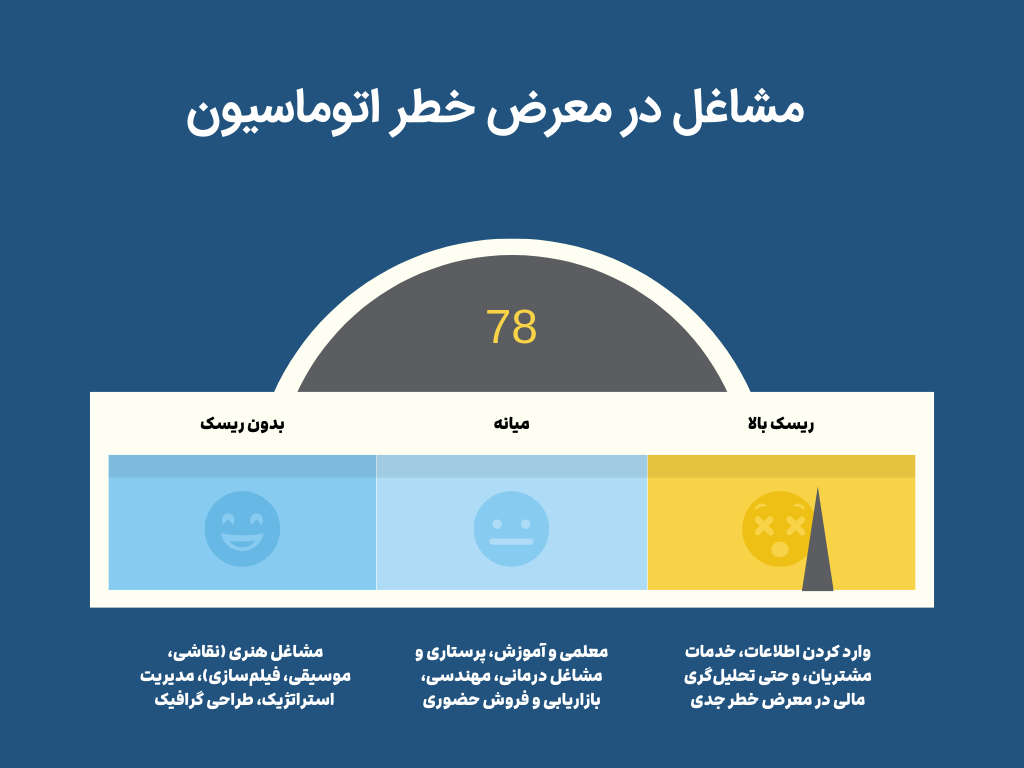

یکی از ملموس ترین و فوری ترین نگرانی ها، تأثیر اتوماسیون مبتنی بر AI بر بازار کار است. سیستمهای هوشمند میتوانند بسیاری از وظایف تکراری، تحلیلی و حتی خلاقانه را با سرعت و دقت بیشتری نسبت به انسان انجام دهند. این موضوع میتواند به جایگزینی گسترده مشاغل انسانی منجر شود.

- اتوماسیون مشاغل: مشاغلی مانند وارد کردن اطلاعات، خدمات مشتریان، و حتی تحلیلگری مالی در معرض خطر جدی قرار دارند.

- شکاف مهارتی: با از بین رفتن مشاغل قدیمی و سنتی، تقاضا برای مهارتهای جدید (مانند مهندسی AI، تحلیل داده و مدیریت سیستمهای هوشمند) به شدت افزایش مییابد. این «شکاف مهارتی» میتواند میلیونها نفر را که توانایی یا فرصت بازآموزی ندارند، از چرخه اقتصادی خارج کند.

- تمرکز ثروت: سود حاصل از این بهره وری فوقالعاده عمدتاً به جیب شرکتهای بزرگ فناوری و صاحبان سرمایهای که الگوریتمها را در اختیار دارند، سرازیر میشود. این امر میتواند نابرابری و شکاف طبقاتی را به سطوح بی سابقه ای برساند.

حتی مشاغل خلاقانه مانند نویسندگی نیز از این قاعده مستثنی نیستند. ابزارهای تولید محتوا با هوش مصنوعی در حال تغییر ماهیت این شغل هستند و این سوال را ایجاد میکنند که آینده کار برای نویسندگان، بازاریابان و خالقان محتوا چگونه خواهد بود. برخی کارشناسان برای مقابله با این چالش، ایدههایی مانند «درآمد پایه همگانی» (Universal Basic Income) را مطرح کردهاند.

۲. خطرات اخلاقی و حریم خصوصی

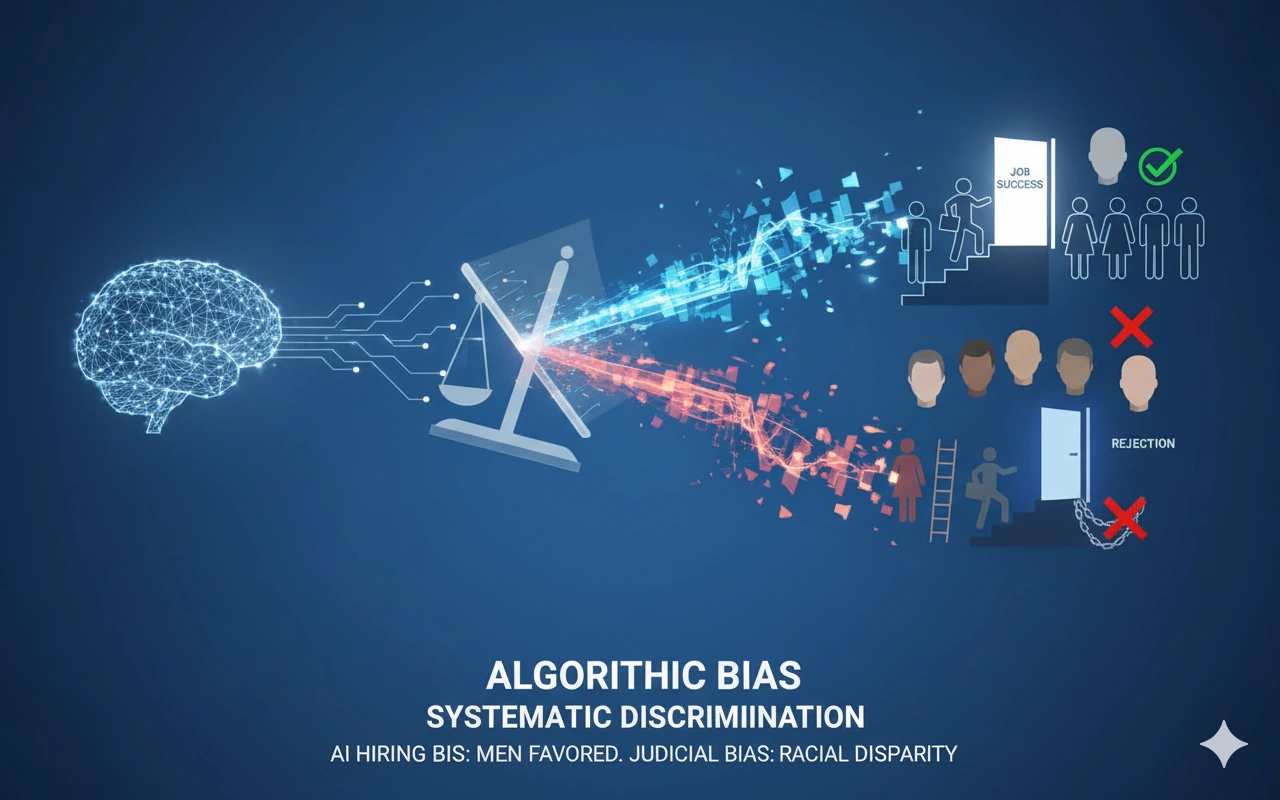

سیستمهای هوش مصنوعی به اندازه دادههایی که با آنها آموزش میبینند، خوب (یا بد) هستند. اگر داده های ورودی منعکسکننده تعصبات و نابرابریهای موجود در جامعه باشند، الگوریتم نیز همان تعصبات را یاد گرفته و در مقیاسی بسیار بزرگتر تکثیر میکند.

- سوگیری الگوریتمی (Algorithmic Bias): این پدیده منجر به تبعیض سیستماتیک میشود. برای مثال، یک سیستم استخدام مبتنی بر AI که با رزومههای موفق گذشته (که عمدتاً متعلق به مردان بوده) آموزش دیده بود، به طور سیستماتیک علیه متقاضیان زن تبعیض قائل میشد. در مثالی دیگر، نرم افزارهای قضایی در آمریکا نشان دادند که در پیش بینی احتمال تکرار جرم توسط متهمان سیاه پوست، خطای بسیار بیشتری نسبت به سفید پوستان دارند.

- نظارت و نقض حریم خصوصی: گسترش فناوریهایی مانند تشخیص چهره در دوربینهای شهری، دولتها و شرکتها را قادر میسازد تا حرکات، ارتباطات و حتی احساسات شهروندان را به صورت دائمی رصد کنند. این سطح از نظارت، تهدیدی جدی برای آزادیهای فردی و حریم خصوصی است.

۳. خطرات امنیتی و نظامی: سلاحهای خودمختار و جنگ سایبری هوشمند

استفاده از هوش مصنوعی در حوزه نظامی، فصل جدید و نگرانکنندهای را در تاریخ جنگها باز کرده است.

- سلاحهای کشنده خودکار (LAWS): این سیستمها که به «رباتهای قاتل» نیز معروفند، قادرند بدون دخالت مستقیم انسان، اهداف را شناسایی کرده و در مورد مرگ و زندگی تصمیم بگیرند. واگذاری چنین تصمیم حیاتی به یک الگوریتم، مسائل اخلاقی و امنیتی عمیقی را به همراه دارد. بسیاری از کارشناسان، از جمله در موسسه آینده حیات، درباره یک مسابقه تسلیحاتی جدید در حوزه AI هشدار میدهند که میتواند ثبات جهانی را به خطر اندازد.

- جنگ سایبری هوشمند: هکرها میتوانند با استفاده از AI، حملات سایبری بسیار پیچیدهتر و مخربتری را طراحی کنند. برای مثال، یک هوش مصنوعی میتواند با تحلیل شبکه های اجتماعی، ایمیل های فیشینگ کاملاً شخصی سازی شده و قانع کننده ای را برای هزاران نفر به صورت خودکار ارسال کند یا آسیب پذیری های امنیتی را با سرعتی فراتر از توان انسان پیدا کرده و از آنها سوء استفاده کند.

۴. خطرات وجودی: ظهور ابرهوش و از دست رفتن کنترل

این دسته از خطرات، بزرگترین و شاید ترسناکترین نگرانیها را در بر میگیرد و به آیندهای دورتر مربوط میشود.

- ابرهوش مصنوعی (Artificial Superintelligence – ASI): به هوشی گفته میشود که در تمام زمینه ها (خلاقیت علمی، خرد عمومی، مهارتهای اجتماعی) به مراتب از باهوشترین انسانها نیز برتر باشد.

- مسئله کنترل (The Control Problem): این سوال اساسی را مطرح میکند: چگونه میتوانیم موجودی را که بسیار باهوشتر از ماست، کنترل کنیم؟ اگر اهداف یک ابرهوش با اهداف و ارزشهای بشریت همسو نباشد، حتی اگر نیت بدی نداشته باشد، میتواند در راستای رسیدن به هدف خود، پیامدهای فاجعه باری برای ما به همراه داشته باشد. نیک باستروم، فیلسوف برجسته، در کتاب خود «ابرهوش» این مسئله را به تفصیل شرح میدهد.

رسیدن به «تکینگی فناوری» (Technological Singularity) – نقطهای که در آن رشد هوش ماشینی از کنترل و درک انسان خارج میشود – بزرگترین تهدید وجودی برای آینده بشریت محسوب میشود. اگر علاقهمند به این موضوعات هستید، مقاله «انواع هوش مصنوعی» را از دست ندهید.

خطرات هوش مصنوعی در حوزه های کلیدی

برای درک بهتر این تهدیدات، بیایید به چند مثال عینی در صنایع مختلف نگاهی بیندازیم.

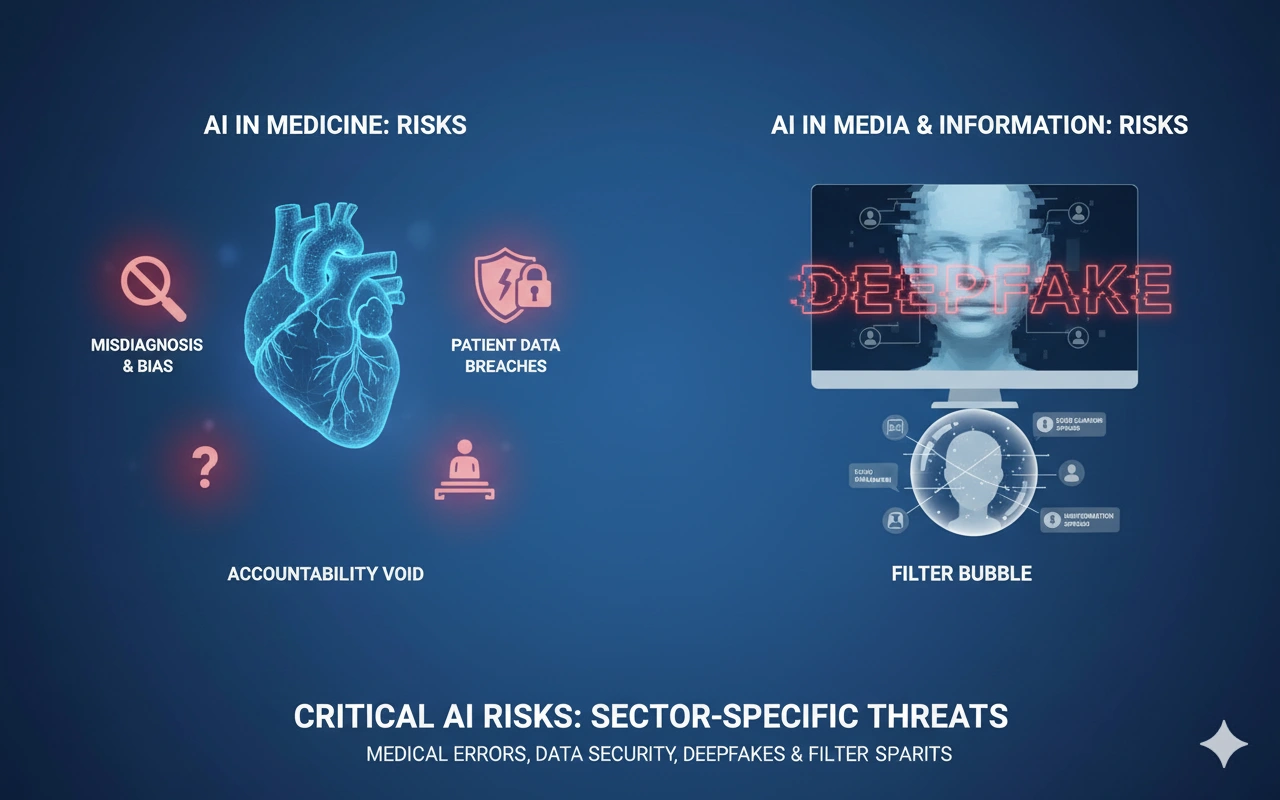

خطرات هوش مصنوعی در پزشکی

با وجود پتانسیل عظیم AI در تشخیص بیماریها، خطراتی نیز وجود دارد:

- تشخیصهای نادرست: اگر یک الگوریتم با دادههای یک گروه جمعیتی خاص آموزش دیده باشد، ممکن است در تشخیص بیماری برای گروههای دیگر دچار خطا شود.

- امنیت دادههای بیماران: پروندههای الکترونیک سلامت حاوی حساسترین اطلاعات افراد هستند. نفوذ به این سیستمها میتواند فاجعهبار باشد.

- مسئولیتپذیری: اگر یک سیستم AI تشخیص اشتباهی بدهد و به بیمار آسیب برسد، چه کسی مسئول است؟ پزشک، بیمارستان، یا شرکت سازنده نرمافزار؟

خطرات هوش مصنوعی در رسانه و اطلاعات

- دیپفیک (Deepfake): این فناوری به هر کسی اجازه میدهد تا ویدئوهای جعلی اما بسیار واقع گرایانه ای از افراد مشهور یا حتی افراد عادی بسازد. از دیپ فیک میتوان برای تولید اخبار جعلی، کلاهبرداری، انتقامجوییهای شخصی و بیاعتبار کردن شخصیتهای سیاسی استفاده کرد.

- حباب فیلتر (Filter Bubble): الگوریتمهای شبکههای اجتماعی با نشان دادن محتوایی که با عقاید ما همسوست، ما را در یک «حباب اطلاعاتی» حبس میکنند. این پدیده باعث تشدید قطبیسازی جامعه و گسترش سریع اطلاعات نادرست (Misinformation) میشود.

راه حل چیست؟ چگونه میتوانیم برای مقابله با خطرات هوش مصنوعی آماده شویم؟

با وجود تمام این نگرانیها، آینده هنوز نوشته نشده است. ما میتوانیم با اقدامات هوشمندانه، مسیر توسعه هوش مصنوعی را به سمت آیندهای امن و مفید هدایت کنیم.

قانونگذاری و نظارت بینالمللی

دولتها و سازمانهای بینالمللی باید چارچوبهای قانونی شفاف و قدرتمندی برای توسعه و استفاده از هوش مصنوعی ایجاد کنند. «قانون هوش مصنوعی» (AI Act) اتحادیه اروپا یک نمونه پیشگام در این زمینه است که سیستمهای AI را بر اساس سطح ریسک آنها طبقهبندی کرده و برای سیستمهای پرخطر، الزامات سخت گیرانه ای وضع میکند. همکاری بین المللی برای جلوگیری از یک «مسابقه تا ته دره» در زمینه ایمنی و اخلاق ضروری است.

توسعه هوش مصنوعی اخلاق محور و مسئولانه (Responsible AI)

شرکتهای فناوری باید مسئولیت پذیری را در هسته طراحی سیستم های خود قرار دهند. این به معنای فراتر رفتن از صرفاً بهینه سازی برای سود و در نظر گرفتن اصول کلیدی است.

چک لیست: ۵ اصل کلیدی برای ساخت یک هوش مصنوعی قابل اعتماد

- شفافیت (Transparency): باید بتوان درک کرد که یک سیستم AI چگونه به یک تصمیم خاص رسیده است.

- عدالت و بیطرفی (Fairness): سیستم باید از تبعیض علیه افراد یا گروههای خاص اجتناب کند.

- پاسخگویی (Accountability): باید مشخص باشد که در صورت بروز خطا، چه کسی مسئول است.

- امنیت و استحکام (Security & Robustness): سیستم باید در برابر حملات و دستکاری مقاوم باشد.

- حریم خصوصی (Privacy): طراحی سیستم باید با رعایت کامل حریم خصوصی کاربران انجام شود.

آموزش عمومی و افزایش آگاهی

مهمترین ابزار ما برای مقابله با خطرات هوش مصنوعی، دانش است. افزایش سواد دیجیتال و درک عمومی از قابلیتها، محدودیتها و خطرات بالقوه این فناوری، شهروندان را قادر میسازد تا تصمیمات آگاهانهتری بگیرند، اخبار جعلی را تشخیص دهند و از سیاستگذارانی حمایت کنند که توسعه مسئولانه AI را در اولویت قرار میدهند.

جمعبندی: هوش مصنوعی، ابزاری قدرتمند که نیازمند مدیریت هوشمندانه است

هوش مصنوعی شمشیری دولبه است. خطراتی که بررسی کردیم – از بیکاری و تبعیض گرفته تا سلاح های خودمختار و تهدیدات وجودی – واقعی و جدی هستند. نادیده گرفتن آنها میتواند عواقب وخیمی برای جامعه بشری داشته باشد.

با این حال، رویکرد صحیح، وحشت و توقف پیشرفت نیست، بلکه هدایت هوشمندانه آن است. با ترکیب قانون گذاری مؤثر، تعهد به توسعه اخلاق محور و افزایش آگاهی عمومی، میتوانیم از مزایای بیشمار هوش مصنوعی بهرهمند شویم و در عین حال، خطرات آن را به حداقل برسانیم. آینده هوش مصنوعی و انسان به تصمیماتی بستگی دارد که ما امروز میگیریم.

اکنون که با ابعاد مختلف خطرات هوش مصنوعی آشنا شدید، کدام یک از این خطرات شما را بیشتر نگران میکند؟ دیدگاه خود را در بخش نظرات با ما و دیگران به اشتراک بگذارید.

برای درک بهتر جنبه های مثبت این فناوری، پیشنهاد میکنیم مقاله ما در مورد «کاربرد های هوش مصنوعی» را نیز مطالعه کنید.

سوالات متداول در مورد خطرات هوش مصنوعی

خطرناک ترین جنبه هوش مصنوعی چیست؟

خطرناکترین جنبه به دیدگاه افراد بستگی دارد. برخی «ابرهوش» کنترلنشده را بزرگترین تهدید وجودی میدانند، در حالی که دیگران معتقدند خطرات امروزی مانند «تبعیض الگوریتمی» و «بیکاری گسترده» فوری تر و ملموس تر هستند.

آیا هوش مصنوعی میتواند انسان را نابود کند؟

در حال حاضر، هوش مصنوعی موجود (ANI) ابزاری در دست انسان است و چنین قابلیتی ندارد. اما در مورد «ابرهوش» آینده، این یک سناریوی نظری است که دانشمندان و فلاسفه برجسته ای مانند استیون هاوکینگ و نیک باستروم نسبت به آن هشدار دادهاند و بر لزوم تحقیقات ایمنی پیشگیرانه تأکید میکنند.

چگونه از خود در برابر خطرات هوش مصنوعی محافظت کنیم؟

با افزایش سواد دیجیتال خود، آگاهی از نحوه جمعآوری و استفاده از دادههایتان، حمایت از شرکتها و سیاستهایی که به اخلاق و شفافیت در AI متعهد هستند، و مشارکت در گفتوگوهای عمومی در این زمینه.

آیا کتابی در مورد خطرات هوش مصنوعی وجود دارد؟

بله، کتاب های معتبری در این زمینه وجود دارد. از جمله معروف ترین آنها میتوان به «ابرهوش: مسیرها، خطرات، استراتژیها» (Superintelligence) نوشته نیک باستروم و «حیات ۳.۰» (Life 3.0) نوشته مکس تگمارک اشاره کرد.